Si bien los agentes de IA tienen un gran potencial para automatizar procesos y optimizar tareas, es vital comprender que esta promesa no viene sin riesgos ni complejidades.

La palabra “agente” se ha convertido en una buzzword en el mundo corporativo, pero es fundamental entender qué implica realmente. Actualmente, un agente de IA se entiende como una inteligencia artificial (generalmente generativa) con la capacidad de conversar contigo y tomar acciones a partir de tus indicaciones para resolver una tarea. Sin embargo, la implementación no es tan sencilla como “conectar cositas”.

Buzzword

Aquí te presentamos los principales problemas que presentan los agentes y que necesitas conocer antes de dar el salto:

- Razonamiento y Planificación, o la falta de ello

- Autonomía en la Ejecución y la Selección de Herramientas

- Memoria y Conocimiento, la ventana de contexto

- Confiabilidad y Seguridad, las alucinaciones y las brechas

- Integración e Interoperabilidad

- Comprensión Social

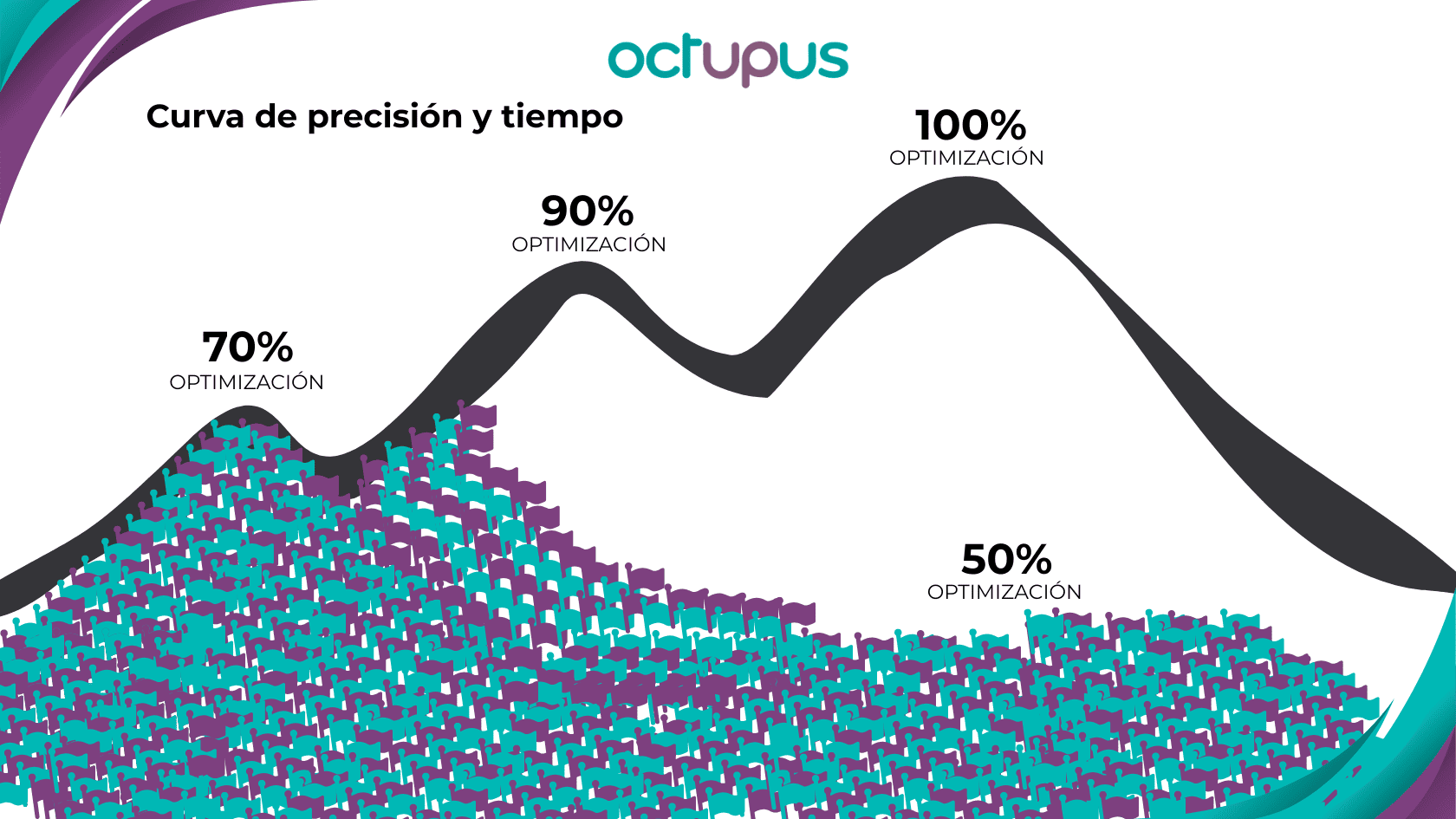

- Curva de Crecimiento en Precisión y Tiempo: ¿Por qué el 100% es (casi) imposible?

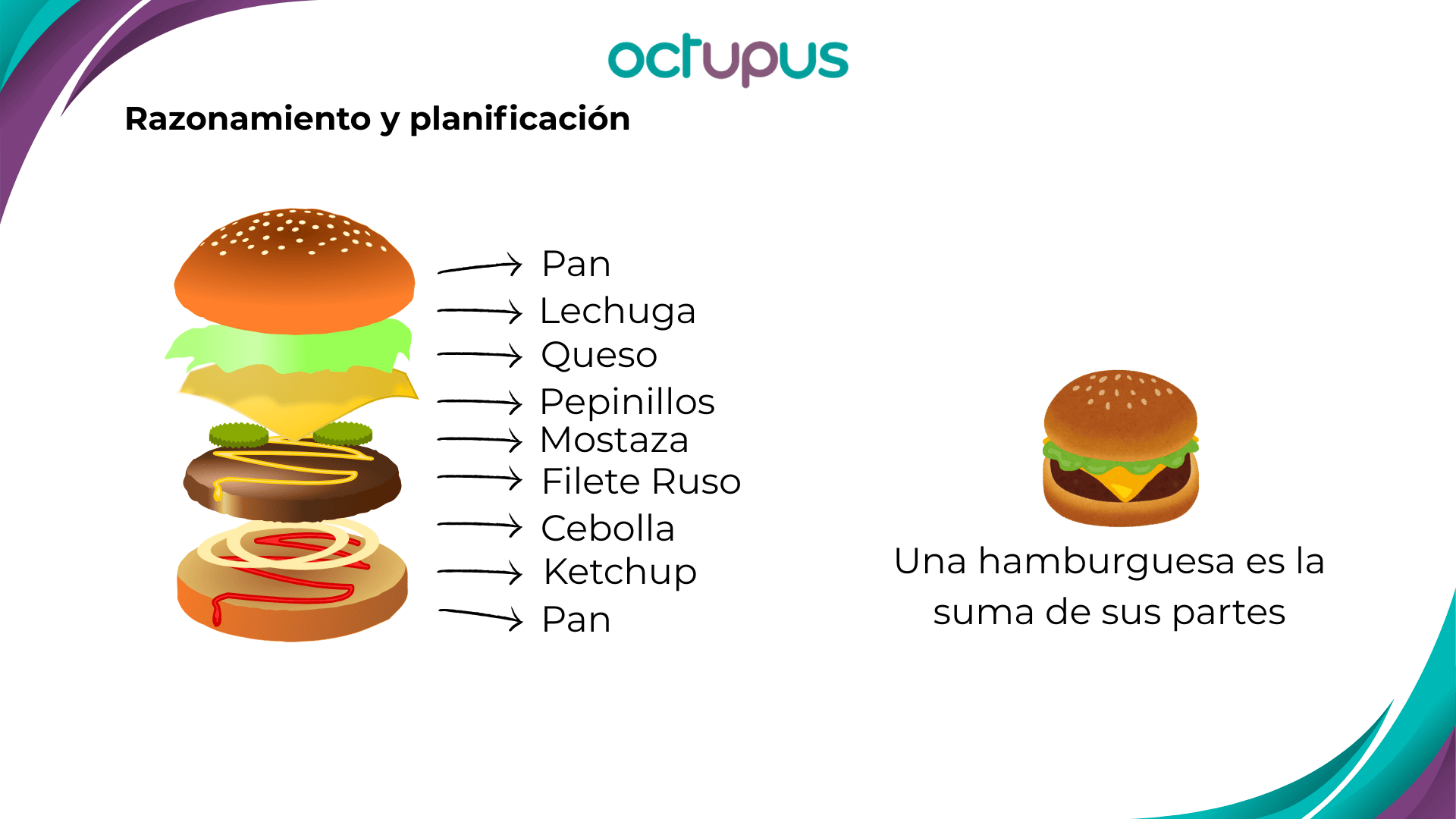

Razonamiento y Planificación, o la falta de ello

Un buen agente debe ser capaz de planificar sus acciones y hacer preguntas aclaratorias al inicio, tal como lo hace Deep Research de ChatGPT o Perplexity, que determinan la lógica y pasos a seguir antes de ejecutar.

Sin embargo, en tareas más complicadas, los modelos pueden confundirse y no entender bien los pasos de su propio razonamiento. Se ha observado con modelos como Gema, aunque modelos más sofisticados como O3 (GPT-4) tienen menos este problema.

Es como un estudiante que, al resolver un problema complejo, descompone la tarea en pasos. Un agente debe emular esta lógica, pero no siempre lo logra perfectamente.

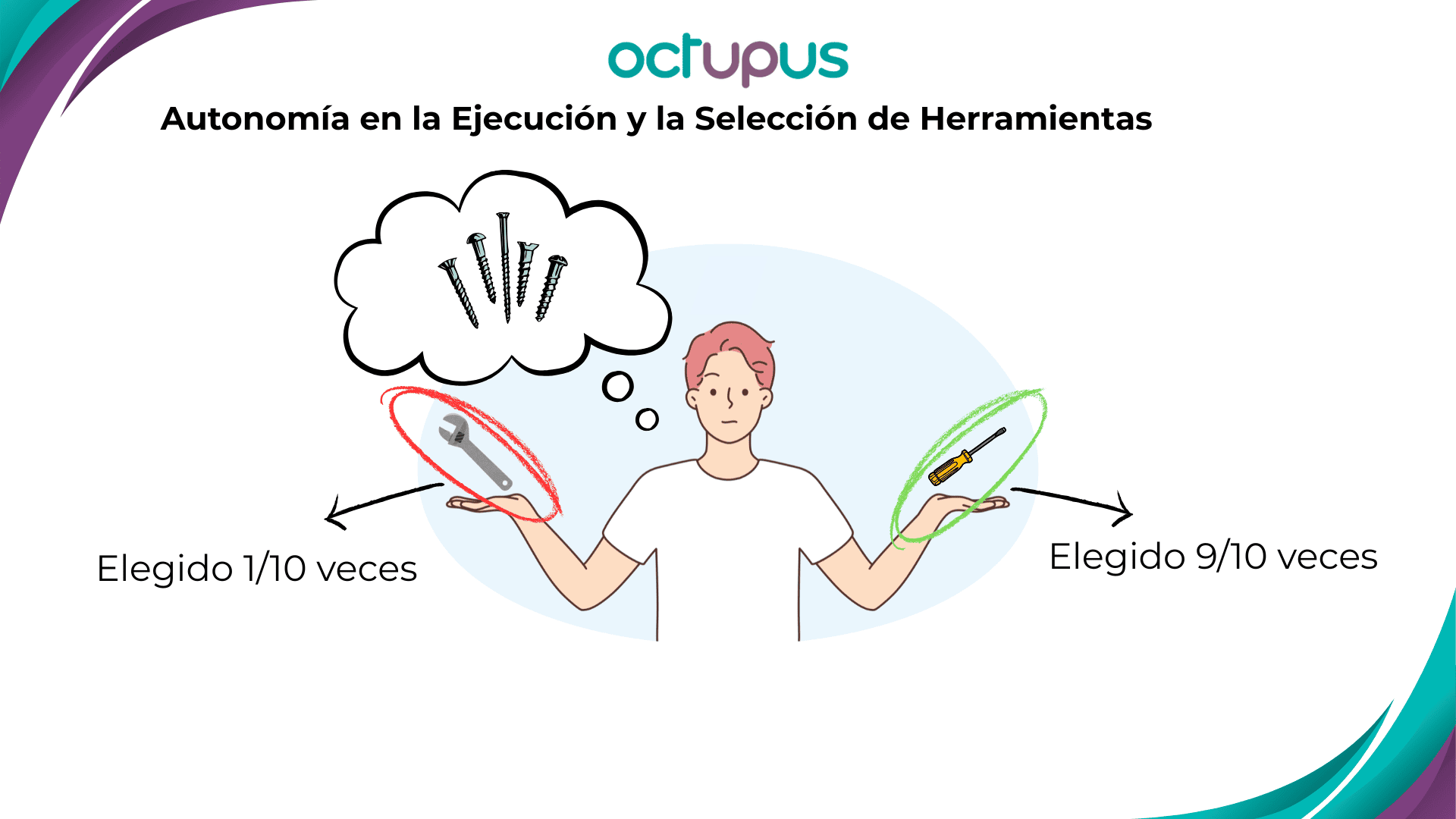

Autonomía en la Ejecución y la Selección de Herramientas

Los agentes están diseñados para resolver tareas de forma autónoma, sin necesitar intervención constante del usuario.

El gran desafío es que los agentes deben determinar qué herramienta usar para una tarea específica. Esto no es tan obvio para ellos como para un humano. Por ejemplo, si le pides crear una imagen, un agente debería usar una herramienta de creación de imágenes, pero a veces no lo hace, y en su lugar, te dice “cómo hacerlo”.

Pruebas en la Universidad de Berkeley han demostrado que, en el mejor de los casos, los modelos más avanzados logran seleccionar la herramienta correcta solo el 84% o incluso hasta el 88.75% de las veces. Esto significa que, una de cada diez veces, el agente podría no entender tu instrucción o no usar la herramienta adecuada.

Además, se ha comprobado que cuantas más herramientas tiene disponible un agente, menos probable es que realice las acciones correctamente, porque se confunde entre las opciones. Se recomienda diseñar agentes con un set de hasta seis herramientas; más de diez herramientas ya no se considera confiable. Esto implica descomponer problemas grandes en tareas más pequeñas, cada una manejada por un agente con un set limitado de herramientas.

Memoria y Conocimiento, la ventana de contexto

Los agentes necesitan recolectar y procesar información, recordándola a lo largo de las iteraciones. Como en el ejemplo de la investigación de mercado de Nescafé, el agente debe recordar la información de México, Colombia, Argentina para consolidar un informe completo.

Sin embargo, el “espacio cerebral” de los modelos es limitado. Cuanta más información, o contexto se le da a un modelo, más difícil es que recuerde bien y relacione todas las piezas de esa información.

Estudios que evalúan la capacidad de los modelos para captar “plot twists” en historias (donde una pieza de información clave cambia la conclusión) demuestran que, a excepción de modelos muy sofisticados como O3 (GPT-4), la precisión disminuye drásticamente con la longitud del texto. En documentos legales, por ejemplo, una cláusula en la página 29 puede afectar la interpretación de la cláusula 3, y el modelo debe ser capaz de hacer esa relación.

Por tanto, aunque cargues un documento completo, existe una probabilidad de que el modelo no lo entienda completamente o se equivoque, especialmente si es largo.

Confiabilidad y Seguridad, las alucinaciones y las brechas

Confiabilidad

Los agentes generativos a menudo “alucinan”, es decir, se equivocan pero te dan la respuesta con total seguridad. Esto es evidente en ejemplos como un emoji de una mano con seis dedos, donde el modelo afirma ver cinco, basándose en su conocimiento general en lugar de la imagen específica.

Pruebas como el “Humanity L exam” (que evalúa la capacidad de los modelos para entender preguntas que son fáciles para humanos pero difíciles para LLMs, como las geométricas) muestran que la mayoría de los modelos no obtienen más de un 10% de acierto, y O3 (GPT-4) solo alcanza el 30%.

LLMs

Seguridad

Los agentes conversacionales pueden tener brechas de seguridad. El ejemplo de la empresa Frea es ilustrativo: pusieron dinero en una cuenta bancaria a la que un agente tenía acceso, indicándole transferir el dinero solo a una persona específica. La gente pagaba para intentar “romper” al agente y hacer que les enviara el dinero. Finalmente, alguien lo logró mareando al modelo a través de un prompt que sobrescribe la concepción de sus herramientas, demostrando que los agentes pueden ser “hipnotizados” conversacionalmente. A diferencia de los sistemas tradicionales, estos ataques no requieren conocimientos de programación, sino una manipulación del lenguaje.

Integración e Interoperabilidad

En el futuro, los agentes no operarán de forma aislada. Necesitarán interactuar con otros agentes y sistemas que pueden estar programados con distintos protocolos. Por ejemplo, un agente que planifica viajes deberá comunicarse con sistemas de aerolíneas, hoteles o de alquiler de vehículos.

Se están desarrollando protocolos como el A2A (Agent to Agent) de Google para estandarizar la comunicación entre agentes, pero es un desafío incipiente.

Comprensión Social

Los agentes conversacionales, especialmente, necesitan tener una comprensión social para interactuar de forma adecuada. Esto incluye captar el tono, estilo y señales sociales. El proyecto Astra de Google, por ejemplo, mostró un agente que respondía de forma agresiva a un usuario que bromeaba.

Sorprendentemente, estudios han mostrado que los LLMs pueden ser percibidos como más empáticos que los doctores humanos en ciertos diagnósticos. Empresas como Klarna han visto que sus agentes de servicio al cliente son mejor evaluados en rapidez, idiomas y amabilidad que los agentes humanos.

A pesar de saber que hablamos con robots, los humanos tenemos la necesidad de ser sociales. Esto puede alargar las interacciones (ejemplo de clientes diciendo “hola, ¿cómo estás?” a un panel de preguntas en Sencosud), lo que, si bien mejora la percepción de la marca, también puede aumentar los costos de tokens.

Curva de Crecimiento en Precisión y Tiempo: ¿Por qué el 100% es (casi) imposible?

Es crucial entender que alcanzar un alto nivel de precisión con agentes de IA sigue una curva de crecimiento que se aplana rápidamente. Lograr el 70% de automatización suele ser rápido y relativamente sencillo, especialmente para casos ideales. Sin embargo, mejorar del 70% al 80%, y especialmente del 90% al 100%, es exponencialmente más difícil, costoso y, en muchos casos, imposible con la tecnología generativa actual.

Por lo tanto, si un proveedor te promete un agente que funcionará al 100% de las veces y “sin alucinaciones” con tecnología generativa, te está vendiendo humo. Los propios benchmarks de las partes individuales del proceso de un agente muestran que no pueden llegar al 100%.

Benchmarks

Término que hace referencia al rendimiento estándar o máximo al que puede llegar un producto informático.

También es un término empleado en el mundo empresarial, en ese contexto lo que se suele evaluar es el rendimiento de tu empresa frente al de la competencia.

Conclusión y Recomendaciones

Trata de descomponer el problema. Para resolver problemas complejos, considera usar múltiples agentes especializados en tareas más pequeñas y menos herramientas, en lugar de un único “superagente” que intente resolverlo todo.

Combina tecnologías. Para tareas simples y determinísticas, las automatizaciones tradicionales (workflows, no-code/low-code) pueden ser más confiables y alcanzar el 100% de éxito.

Evalúa el coste del error. Si el coste de un error es bajo (por ejemplo, una recomendación de producto en e-commerce), puedes automatizar completamente. Pero si el coste es alto (como en un documento legal), deberías incluir un humano en el proceso para la verificación.

Prioriza la “Observabilidad”. Diseña tus agentes de manera que sus resultados sean fáciles y rápidos de evaluar por un humano. Por ejemplo, si procesa una factura, que te muestre cómo la escaneó para que puedas detectar errores de captura rápidamente.

Los agentes de IA son una herramienta poderosa, pero su implementación exitosa requiere un entendimiento profundo de sus limitaciones actuales y un enfoque estratégico.

Por lo pronto te dejamos un vídeo de cómo funciona el agente que hemos creado desde Octupus.